|

UNIVERSIDAD CATOLICA DE EL SALVADOR

CENTRO REGIONAL DE ILOBASCO

FACULTAD MULTIDISCIPLINARIA

LICENCIATURA EN CIENCIAS DE LA EDUCACIÓN

ESPECIALIDAD EN EDUCACION BASICA

``BLOG EDUCATIVO``

ASIGNATURA:

Tecnologia y Educacion.

FACILITARA

ING, Silvia Carolina Rivera Herrera.

ESTUDIANTE:

Tomas Antonio González Bonilla.

Ilobasco 13 De Mayo 2020

Introducción:

En este blog encontraras un alto contenido informático,

que te ayudara a reforzar y expandir tus conocimientos. Para comenzar

me gustaría iniciar con la historia de la internet, donde conocerás sus inicios

y su evolución también hablaremos sobre como nacieron las computadoras cuales

fueron las primeras computadoras y su evolución hasta la actualidad, pero que sería

de las computadoras sin su sistema operativo, por ese motivo hablaremos de Microsoft

Windows sus precursores, ya que las computadoras nos facilitan el trabajo

existe una herramienta muy conocida por las empresas, docentes y estudiantes, nos

referimos a Microsoft office un software de paga muy usado, no solo lo conocerás

también mostraremos como usarlo.

Orígenes de Internet

La primera descripción registrada de las

interacciones sociales que se podían habilitar a través de la red fue una serie de memorandos escritos

por J.C.R. Licklider, del MIT, en agosto de 1962, en los que describe su

concepto de “Red galáctica”. Imaginó un conjunto de ordenadores interconectados

globalmente, a través de los que todo el mundo podría acceder rápidamente a datos

y programas desde cualquier sitio. En espíritu, el concepto era muy similar a

la Internet de hoy en día. Licklider era el director del programa de

investigación informática de DARPA, que comenzó en octubre

de 1962. Mientras estaba en DARPA convenció a sus sucesores en dicha agencia

(Ivan Sutherland, Bob Taylor y Lawrence G. Roberts, investigador del MIT), de

la importancia de su concepto de red.

Leonard Kleinrock, del MIT, publicó el primer documento sobre

la teoría de conmutación de paquetes en

julio de 1961 y el primer libro sobre el tema en

1964 Kleinrock convenció a Roberts de la factibilidad teorética de comunicarse

usando paquetes en vez de circuitos, lo que fue un gran paso en el viaje hacia

las redes informáticas. El otro paso clave fue conseguir que los ordenadores

hablasen entre sí. Para explorar esta idea, en 1965, trabajando con Thomas

Merrill, Roberts conectó el ordenador TX-2, en Massachusetts, con el Q-32, en

California, mediante una línea telefónica conmutada de baja velocidad, creando

la primera (aunque

pequeña) red de área amplia del mundo. El

resultado de este experimento fue la constatación de que los ordenadores con

tiempo compartido podían trabajar bien juntos, ejecutando programas y

recuperando datos según fuese necesario en el equipo remoto, pero que el

sistema telefónico de conmutación de circuitos era totalmente inadecuado para

esa tarea. Se confirmó la convicción de Kleinrock de la necesidad de la

conmutación de paquetes.

A finales de 1966, Roberts entró en DARPA para

desarrollar el concepto de redes informáticas y rápidamente creó su plan

para “ARPANET“, que publicó en 1967. En la

conferencia en la que presentó el artículo había otra ponencia sobre el concepto

de redes de paquetes, que venía del Reino Unido, de la mano de Donald Davies y

Roger Scantlebury, del NPL. Scantlebury le comentó a Roberts el trabajo del NPL

y el de Paul Baran y otras personas de RAND. El grupo RAND había escrito

un artículo sobre redes

de conmutación de paquetes para cifrar comunicaciones de voz en

el ejército en 1964. La labor del MIT (1961-1967), de RAND (1962-1965) y del

NPL (1964-1967) se había llevado a cabo en paralelo sin que los investigadores

conociesen el trabajo de los demás. Se adoptó el término “paquete” del trabajo

del NPL, y la velocidad de línea propuesta en el diseño de ARPANET pasó de 2,4

kbps a 50 kbps.

En agosto de 1968, después de que Roberts y la

comunidad financiada por DARPA redefinieran la estructura general y las

especificaciones de ARPANET, DARPA publicó una solicitud de presupuesto para

desarrollar uno de los componentes clave, los conmutadores de paquetes llamados

procesadores de mensajes de interfaz (IMP). La solicitud de presupuesto la ganó

en diciembre de 1968 un grupo liderado por Frank Heart, de Bolt, Beranek y

Newman (BBN). Mientras el equipo de BNN trabajaba en los IMP con Bob Kahn

desempeñando un importante papel en el diseño arquitectónico general de

ARPANET, Roberts, junto con Howard Frank y su equipo de Network Analysis

Corporation, diseñaron la topología y la economía de la red. El sistema de

medición de la red lo preparó el equipo de Kleinrock en UCLA.

Debido al temprano desarrollo de Kleinrock de

la teoría de conmutación de paquetes y a su trabajo en el análisis, el diseño y

la medición, su Network Measurement Center de UCLA fue seleccionado como el

primer nodo de ARPANET. Se recogió el fruto de estos esfuerzos en septiembre de

1969, cuando BBN instaló el primer IMP en UCLA y se conectó el primer host. El

proyecto de Doug Engelbart, “Augmentation of Human Intellect” (aumento del

intelecto humano, que incluía NLS, un antecedente del sistema de hipertexto),

en el Standford Research Institute (SRI), fue el segundo nodo. El SRI estaba

detrás del Network Information Center, liderado por Elizabeth (Jake) Feinler,

que incluía funciones como mantenimiento de tablas de nombres de host para

asignar direcciones, así como de un directorio de RFC.

Un mes más tarde, cuando el SRI se conectó a

ARPANET, se envió el primer mensaje de host a host desde el laboratorio de

Kleinrock hasta el SRI. Se añadieron dos nodos más, en la Universidad de

California en Santa Bárbara y en la Universidad de Utah. Estos dos últimos

nodos incorporaron proyectos de visualización de aplicaciones, con Glen Culler

y Burton Fried, de la Universidad de California en Santa Bárbara, investigando

métodos para mostrar funciones matemáticas usando pantallas de almacenamiento

para resolver el problema de la actualización en la red, y Robert Taylor e Ivan

Sutherland, de Utah, investigando métodos de representación 3D en la red. De

esta manera, a finales de 1969, había cuatro hosts conectados en la ARPANET

inicial, e Internet iniciaba su trayectoria. Incluso en esta primera etapa,

conviene destacar que la investigación sobre redes incorporaba trabajo sobre la

red subyacente y trabajo sobre cómo usar la red. Esta tradición continúa hoy en

día.

Un mes más tarde, cuando el SRI se conectó a

ARPANET, se envió el primer mensaje de host a host desde el laboratorio de

Kleinrock hasta el SRI. Se añadieron dos nodos más, en la Universidad de

California en Santa Bárbara y en la Universidad de Utah. Estos dos últimos

nodos incorporaron proyectos de visualización de aplicaciones, con Glen Culler

y Burton Fried, de la Universidad de California en Santa Bárbara, investigando

métodos para mostrar funciones matemáticas usando pantallas de almacenamiento

para resolver el problema de la actualización en la red, y Robert Taylor e Ivan

Sutherland, de Utah, investigando métodos de representación 3D en la red. De

esta manera, a finales de 1969, había cuatro hosts conectados en la ARPANET

inicial, e Internet iniciaba su trayectoria. Incluso en esta primera etapa,

conviene destacar que la investigación sobre redes incorporaba trabajo sobre la

red subyacente y trabajo sobre cómo usar la red. Esta tradición continúa hoy en

día.

En los siguientes años, se añadieron

rápidamente ordenadores a ARPANET, y se siguió trabajando para conseguir un

protocolo de host a host funcionalmente completo y otro software de red. En

diciembre de 1970, el Network Working Group (NWG), bajo el liderazgo de S.

Crocker, terminó el protocolo de host a host inicial de ARPANET, llamado

Network Control Protocol (NCP). Cuando los sitios de ARPANET terminaron de

implementar NCP, en el periodo de 1971 a 1972, los usuarios De la red pudieron,

por fin, comenzar a desarrollar aplicaciones.

En octubre de 1972, Kahn organizó una gran

demostración de ARPANET, que tuvo mucho éxito, en la International Computer

Communication Conference (ICCC). Fue la primera demostración pública de esta

nueva tecnología de redes. En 1972 también se introdujo la aplicación “hot”

inicial, el correo electrónico. En marzo, Ray Tomlinson, de BBN, escribió el

software básico de envío y lectura de mensajes de correo electrónico, motivado

por la necesidad de los desarrolladores de ARPANET de un mecanismo sencillo de

coordinación. En julio, Roberts amplió su utilidad escribiendo la primera

utilidad de correo electrónico para hacer listas de mensajes, leerlos

selectivamente, archivarlos, reenviarlos y responder a los mismos. A partir de

ese momento, el correo electrónico se convirtió en la aplicación de red más

importante durante más de una década. Esto presagió el tipo de actividad que

vemos hoy en día en la World Wide Web, es decir, un crecimiento enorme de todo

tipo de tráfico “de persona a persona”.

Los primeros conceptos de Internet

La ARPANET original se convirtió en Internet.

Internet se basó en la idea de que habría múltiples redes independientes con un

diseño bastante arbitrario, empezando por ARPANET como red pionera de

conmutación de paquetes, pero que pronto incluiría redes de paquetes satélite,

redes terrestres de radiopaquetes y otras redes. Internet tal y como la

conocemos hoy en día plasma una idea técnica subyacente fundamental, que es la

de red de arquitectura abierta. En este enfoque, la selección de una tecnología

de redes no la dictaba una arquitectura particular de redes, sino que la podía

elegir libremente un proveedor y hacerla trabajar con las demás redes a través

de una “metaarquitectura de interredes”. Hasta ese momento solo había un método

general para federar redes. Era el método tradicional de conmutación de

circuitos, en el que las redes se interconectaban a nivel de circuito, pasando

bits individuales de forma síncrona a través de una parte de un circuito

completo entre un par de ubicaciones finales. Recordemos que Kleinrock había

demostrado en 1961 que la conmutación de paquetes era un método de conmutación

más eficiente. Además de la conmutación de paquetes, las interconexiones entre

redes con fines especiales eran otra posibilidad. Aunque había otras maneras

limitadas de interconectar redes diferentes, era necesario usar una como

componente de la otra, y la primera no actuaba como par de la segunda ofreciendo

servicios de extremo a extremo.

En una red de arquitectura abierta, las redes

individuales se pueden diseñar y desarrollar por separado, cada una con su

propia interfaz única, que puede ofrecerse a usuarios y otros

proveedores, incluyendo otros proveedores de Internet. Se puede diseñar

cada red según el entorno específico y los requisitos de los usuarios de esa

red. En general, no existen restricciones sobre el tipo de redes que se pueden

incluir o sobre su alcance geográfico, aunque ciertas consideraciones

pragmáticas dictaminan lo que tiene sentido ofrecer.

La idea de las redes de arquitectura abierta la

introdujo por primera vez Kahn, poco después de llegar a DARPA, en 1972. Su

labor era originalmente parte del programa de radiopaquetes, pero posteriormente

se convirtió en un programa independiente por derecho propio. En aquel momento,

el programa se llamó “Internetting”. La clave para que el sistema de

radiopaquetes funcionase era un protocolo de extremo a extremo fiable que

pudiera mantener una comunicación efectiva frente a bloqueos y otras

interferencias de radio, o soportar cortes intermitentes como los causados

cuando se entra en un túnel o el terreno bloquea la señal. Kahn, al principio,

se planteó desarrollar un protocolo solo para la red de radiopaquetes, ya que

así evitaría tratar con una multitud de diferentes sistemas operativos, y

seguir usando NCP.

Sin embargo, NCP no tenía la capacidad de

dirigirse a redes (ni a máquinas) que estuvieran más allá de un IMP de destino

de ARPANET, de modo que también hacía falta algún cambio en NCP. (Se asumía que

ARPANET no se podía cambiar en este sentido). NCP dependía de ARPANET para

ofrecer fiabilidad de extremo a extremo. Si se perdía algún paquete, el

protocolo (y probablemente las aplicaciones a las que este daba soporte) se

pararía de repente. En este modelo, NCP no tenía control de errores de host de

extremo a extremo, ya que ARPANET sería la única red, y tan fiable que no haría

falta un control de errores por parte de los hosts. Así pues, Kahn decidió

desarrollar una nueva versión del protocolo que podría cubrir las necesidades

de un entorno de redes de arquitectura abierta. Este protocolo se llamaría más

adelante Protocolo de Control de Transmisión/Protocolo de Internet (TCP/IP).

Mientras que NCP tendía a actuar como un controlador de dispositivo, el nuevo

protocolo se parecería más a un protocolo de comunicaciones.

Cuatro reglas básicas fueron fundamentales en

la primera concepción de Kahn:

Cada red diferente debería mantenerse por sí

misma, y no debía ser necesario cambio interno alguno para que esas redes se

conectasen a Internet.

La comunicación se haría en base al mejor

esfuerzo. Si un paquete no llegaba a su destino final, se retransmitía poco

después desde el origen.

Se usarían cajas negras para conectar las

redes; más adelante, estas cajas negras se llamarían puertas de enlace y

enrutadores. Las puertas de enlace no guardarían información acerca de los

flujos individuales de paquetes que pasaban por las mismas, manteniendo su

sencillez y evitando la complicación de la adaptación y la recuperación a

partir de varios modos de error.

No habría control global a nivel operativo.

Otros problemas clave que había que resolver

eran:

Algoritmos para evitar que los paquetes

perdidos impidiesen permanentemente las comunicaciones y permitir que dichos

paquetes se retransmitiesen correctamente desde el origen. Ofrecer “segmentación” de host a host para que

se pudiesen enviar múltiples paquetes desde el origen hasta el destino, según

el criterio de los hosts, si las redes intermedias lo permitían.

Funciones de puerta de enlace para poder

reenviar paquetes de manera adecuada. Esto incluía interpretar encabezados IP

para enrutar, manejar interfaces, dividir paquetes en partes más pequeñas si

era necesario, etc.

La necesidad de sumas de verificación de

extremo a extremo, reensamblaje de paquetes a partir de fragmentos y detección

de duplicados.

La necesidad de un abordaje global Técnicas para el control del flujo de host a

host.

Interfaces con los diferentes sistemas

operativos

Había además otras preocupaciones, como la

eficacia en la implementación y el rendimiento de las redes, pero estas, en

principio, eran consideraciones secundarias.

Kahn comenzó a trabajar en un conjunto

orientado a las comunicaciones de principios para sistemas operativos en BBN y

documentó algunas de sus ideas iniciales en un memorándum interno de BBN

titulado “Principios de comunicación para sistemas

operativos“. En este momento, se dio

cuenta de que sería necesario conocer los detalles de implementación de cada

sistema operativo para tener la oportunidad de integrar cualquier protocolo

nuevo de una forma eficaz. Así pues, en la primavera de 1973, tras comenzar el

trabajo de lo que sería Internet, pidió a Vint Cerf (que entonces estaba en

Stanford) que colaborase con él en el diseño detallado del protocolo. Cerf

había estado involucrado de lleno en el diseño y desarrollo original de NCP, y

ya tenía conocimiento sobre las interfaces de los sistemas operativos

existentes. Así que, armados con el enfoque arquitectónico de Kahn para la

parte de comunicaciones y con la experiencia de Cerf en NCP, se unieron para

crear lo que se convertiría en TCP/IP.

Su colaboración fue muy productiva, y la

primera versión escrita del

enfoque resultante se distribuyó en una reunión especial del International

Network Working Group (INWG), que se había creado en una conferencia de la

Universidad de Sussex en septiembre de 1973. Se había invitado a Cerf a

presidir ese grupo, y aprovechó la ocasión para celebrar una reunión con los

miembros del INWG que eran numerosos en la Conferencia de Sussex.

Emergieron algunos enfoques básicos de esta

colaboración entre Kahn y Cerf:

La comunicación entre dos procesos consistiría

lógicamente en una secuencia larguísima de bytes (los llamaron octetos). Se

usaría la posición de un octeto en la secuencia para identificarlo.

La comunicación entre dos procesos consistiría

lógicamente en una secuencia larguísima de bytes (los llamaron octetos). Se

usaría la posición de un octeto en la secuencia para identificarlo.

El control de flujo se haría usando ventanas

deslizantes y confirmaciones (acks). El destino podría decidir cuándo

confirmar, y cada ack devuelta se acumularía para todos los paquetes recibidos

hasta ese momento.

No se concretó la manera exacta en la que el

origen y el destino acordarían los parámetros de división de particiones que se

usaría. Al principio se usaban los valores predeterminados.

Aunque en ese momento se estaba desarrollando

Ethernet en Xerox PARC, la proliferación de LAN no se imaginaba entonces, y

mucho menos la de los ordenadores personales y las estaciones de trabajo. El

modelo original era de redes nacionales como ARPANET, y se esperaba que

existiese un pequeño número de las mismas. Así pues, se usó una dirección IP de

32 bits, en la que los primeros 8 bits indicaban la red y los 24 bits restantes

designaban el host de esa red. Fue evidente que habría que reconsiderar esta

suposición, la de que sería suficiente con 256 redes en el futuro inmediato,

cuando empezaron a aparecer las LAN a finales de los años 70.

El artículo original de Cerf y Kahn sobre

Internet describía un protocolo, llamado TCP, que ofrecía todos los servicios

de transporte y reenvío de Internet. La intención de Kahn era que el protocolo

TCP soportase una serie de servicios de transporte, desde la entrega

secuenciada totalmente fiable de datos (modelo de circuito virtual) hasta un

servicio de datagrama, en el que la aplicación hacía un uso directo del

servicio de red subyacente, lo que podía implicar la pérdida, la corrupción y

la reordenación de paquetes. Sin embargo, el primer intento de implementar TCP

produjo una versión que solo permitía circuitos virtuales. Este modelo funcionó

bien para aplicaciones de inicio de sesión remoto y transferencia de archivos,

pero algunos de los primeros trabajos en aplicaciones de red avanzadas, en

particular la voz por paquetes de los años 70, dejaron claro que en algunos

casos la pérdida de paquetes no podía ser corregida por TCP, y la aplicación

debería encargarse de ella. Esto llevó a reorganizar el TCP original en dos

protocolos, el IP simple, que solo dirigía y reenviaba paquetes individuales, y

el TCP por separado, que se ocupaba de funciones del servicio como el control

de flujos y la recuperación de paquetes perdidos. Para las aplicaciones que no

querían los servicios de TCP, se añadió una alternativa llamada Protocolo de

datagramas de usuario (UDP) para ofrecer acceso directo a los servicios básicos

de IP.

Una de las principales motivaciones iniciales

de ARPANET e Internet era compartir recursos, por ejemplo, permitir a los

usuarios de las redes de radiopaquetes acceder a sistemas de tiempo compartido

conectados a ARPANET. Conectar ambos era mucho más económico que duplicar estos

ordenadores tan caros. Sin embargo, aunque la transferencia de archivos y el

inicio de sesión remoto (Telnet) eran aplicaciones muy importantes, el correo

electrónico ha sido, probablemente, la innovación de aquella época con mayor

impacto. El correo electrónico ofreció un nuevo modelo de comunicación entre

las personas, y cambió la naturaleza de la colaboración, primero en la creación

de la propia Internet (como se comenta a continuación) y después para gran

parte de la sociedad.

Una de las principales motivaciones iniciales

de ARPANET e Internet era compartir recursos, por ejemplo, permitir a los

usuarios de las redes de radiopaquetes acceder a sistemas de tiempo compartido

conectados a ARPANET. Conectar ambos era mucho más económico que duplicar estos

ordenadores tan caros. Sin embargo, aunque la transferencia de archivos y el

inicio de sesión remoto (Telnet) eran aplicaciones muy importantes, el correo

electrónico ha sido, probablemente, la innovación de aquella época con mayor

impacto. El correo electrónico ofreció un nuevo modelo de comunicación entre

las personas, y cambió la naturaleza de la colaboración, primero en la creación

de la propia Internet (como se comenta a continuación) y después para gran

parte de la sociedad.

Se propusieron otras aplicaciones en los

primeros tiempos de Internet, incluyendo la comunicación de voz basada en

paquetes (el precursor de la telefonía por Internet), varios modelos para

compartir archivos y discos y los primeros programas “gusano” que mostraron el

concepto de agentes (y, por supuesto, virus). Un concepto clave de Internet es

que no se había diseñado solo para una aplicación, sino como una

infraestructura general en la que se podían concebir nuevas aplicaciones, como

se ilustró más adelante con la aparición de la World Wide Web. Es la naturaleza

generalista del servicio que ofrecen TCP e IP la que lo hace posible.

1°

Generación de computadoras –

1946 a 1955: para esta época, la tecnología utilizada eran los tubos al vacío,

esos mismos son famosos por haber posibilitado el desarrollo de la electrónica

hacia la mitad del siglo XX. Por esta razón, los ordenadores eran desarrollados

con válvulas electrónicas de vacío. Se caracterizaban principalmente por tener

un tamaño enorme, no disponer de sistema operativo, sino de una tarjeta

perforada para almacenar toda la información y eran utilizados exclusivamente

por las fuerzas militares y la industria científica. De acuerdo con el portal

web Wikipedia y las referencias encontradas en la Enciclopedia Actual de la

Informática, las computadoras que marcaron el hito de la primera generación

fueron:

para mas informacion puede visitar el siguiente link historia de la internet

LA

HISTORIA DE LA GENERACIÓN DE COMPUTADORAS

Aunque

solo a partir de los años 90´ los ordenadores pudieron ser reconocidos por una

gran parte de la población, y en el 2000 empezaron a hacer parte del diario

vivir de las personas, lo cierto es que su historia se remonta a muchos años

atrás con una amplia generación de computadoras que, aún en pleno siglo XXI,

todavía las desconocen.

Aunque

solo a partir de los años 90´ los ordenadores pudieron ser reconocidos por una

gran parte de la población, y en el 2000 empezaron a hacer parte del diario

vivir de las personas, lo cierto es que su historia se remonta a muchos años

atrás con una amplia generación de computadoras que, aún en pleno siglo XXI,

todavía las desconocen.

Si

bien en 1946 se desarrolla la primera computadora digital electrónica

denominada ENIAC, para el año de 1936, (10 años atrás) ya se estaba dando forma

y significado a lo que hoy se conoce como computadora u ordenador, gracias a la

fabricación de la Z1, la que para muchos es la primera computadora programable

de la historia, a pesar de ser reconocida como una calculadora mecánica

binaria.

Desde

ordenadores carentes de sistema operativo, construidos con electrónicas de

válvulas, pasando por transistores hasta llegar a microprocesadores, son solo

algunas de las características que destacan a cada generación de computadoras.

Pero, ¿cómo eran esas primeras máquinas y para qué eran utilizadas? ¡Echemos un

vistazo atrás para entender mejor todo esto!

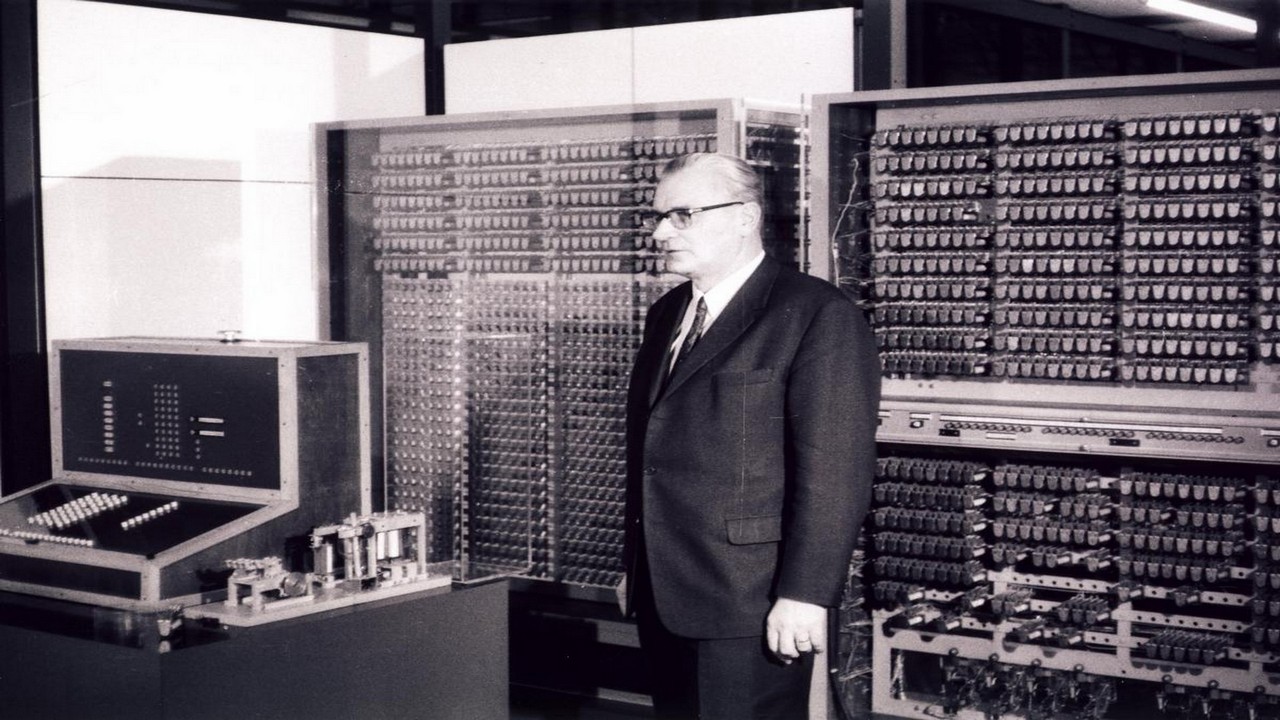

La

Zuse Z1: Diseñada

por el ingeniero alemán Konrad Zuse en 1936 bajo el sistema electro-mecánico y

con financiamiento propio de su inventor y el de sus allegados. Se dice que fue

construida en el departamento de los padres de Zuse, debido a que el gobierno

Nazi no confiaba en el trabajo de este informático.

La

Zuse Z1: Diseñada

por el ingeniero alemán Konrad Zuse en 1936 bajo el sistema electro-mecánico y

con financiamiento propio de su inventor y el de sus allegados. Se dice que fue

construida en el departamento de los padres de Zuse, debido a que el gobierno

Nazi no confiaba en el trabajo de este informático.

La

Zuse Z2: Como

todo lo que se crea por primera vez no es perfecto, Zuse decidió mejorar entre

los años 1936 y 1939 su gran invento. Gracias a la ayuda de su amigo Helmut

Schreyer, quien lo aconsejó que cambiara el sistema mecánico por tecnología de

circuito electrónico, implementó relés telefónicos para conocer la viabilidad

del proyecto, obteniendo como resultado una máquina un poco más veloz, pero

casi imposible de realizar debido a la escasez de la época de válvulas

termoiónicas.

ENIAC: Aunque su creación se les

amerita a los ingenieros John Presper Eckert y John William Mauchly en 1944,

realmente fue un grupo conformado por 6 mujeres las que programaron esta

computadora. Así como la Z2, la ENIAC se desarrolló como una máquina meramente

experimental y no de producción.

ENIAC: Aunque su creación se les

amerita a los ingenieros John Presper Eckert y John William Mauchly en 1944,

realmente fue un grupo conformado por 6 mujeres las que programaron esta

computadora. Así como la Z2, la ENIAC se desarrolló como una máquina meramente

experimental y no de producción. La

Z4: Debido

a que la computadora Z3 fue destruida en 1943 en un bombardeo realizado en

Berlín durante la Segunda Guerra Mundial, Konrad Zuse diseñó nuevamente una

máquina como resultado final de todas sus anteriores versiones, utilizando

tarjetas perforadas y el sistema de relés. Es conocida como la 1° computadora

en ser vendida en todo el mundo en 1950.

La

Z4: Debido

a que la computadora Z3 fue destruida en 1943 en un bombardeo realizado en

Berlín durante la Segunda Guerra Mundial, Konrad Zuse diseñó nuevamente una

máquina como resultado final de todas sus anteriores versiones, utilizando

tarjetas perforadas y el sistema de relés. Es conocida como la 1° computadora

en ser vendida en todo el mundo en 1950.

La

EDVAC: De

toda la generación de computadoras hasta ahora existente, fue la segunda

programable y la primera en usar un programa informático de almacenamiento. Su

creación se le atribuye al laboratorio de investigación de balística de Estados

Unidos de la Universidad de Pensilvania en el año de 1949.

Entre

los años 1951 a 1955 se fabricaron y construyeron varios modelos de

computadoras que marcaron el inicio comercial de este gran invento tecnológico.

A este selecto grupo pertenecen La UNIVAC I creada por los mismos inventores de

la ENIAC y catalogada como la primera computadora comercial procreada en

Estados Unidos y La Zuse Z22 desarrollada también por Konrad Zuse bajo el

sistema de tubos de vació.

Entre

los años 1951 a 1955 se fabricaron y construyeron varios modelos de

computadoras que marcaron el inicio comercial de este gran invento tecnológico.

A este selecto grupo pertenecen La UNIVAC I creada por los mismos inventores de

la ENIAC y catalogada como la primera computadora comercial procreada en

Estados Unidos y La Zuse Z22 desarrollada también por Konrad Zuse bajo el

sistema de tubos de vació.

2°

Generación de computadoras –

1958 a 1964: La gran hazaña de esta generación fue la sustitución de válvulas

de vacío por los transistores, acompañada del uso de memorias de núcleo de

ferritas y tambores magnéticos para almacenar la información, los cuales

permitieron la fabricación de computadoras de menor tamaño, caracterizadas por

una mejor potencia, rapidez y fiabilidad. En este periodo se empezaron a

utilizar lenguajes de alto nivel como ALGOL, FORTRAN y COBOL, siendo estos dos

últimos los lenguajes de programación que ayudó a desarrollar la gran

científica de la computación Grace Hopper, gracias a sus conocimientos sobre

FLOW-MATIC. Las computadoras más destacadas durante este tiempo fueron:

IBM 1620: Fue un ordenador creado principalmente para uso científico y el primero de este tipo en ser estimado como económico. Poseía una memoria de núcleo magnético y se lanzó al mercado en 1959.

3°

Generación de computadoras – 1964 a 1971: Con la invención del circuito

cerrado o chip por parte de los ingenieros estadounidenses Jack S. Kilby y

Robert Noyce se revoluciona por completo el diseño de las computadoras.

Aparecen los primeros discos magnéticos y los componentes electrónicos se

integran en una sola pieza o chip que albergan en su interior condensadores,

transistores y diodos, los cuales ayudan a aumentar notablemente la velocidad

de carga y a reducir el consumo de energía eléctrica. En esta generación las

computadoras se caracterizan por tener mayor flexibilidad y fiabilidad, ser de

menor tamaño y ocupar poco espacio. Las máquinas más sobresalientes de la época

fueron:

CDC

6600: Fue

creado en el año 1965 por el estadounidense Seymour Cray y se le destinó un uso

principal para la investigación de la física de alta energía nuclear.

CDC

6600: Fue

creado en el año 1965 por el estadounidense Seymour Cray y se le destinó un uso

principal para la investigación de la física de alta energía nuclear.

IBM 360: Diseñada por la empresa IBM, fue una de las computadoras que influyó en el desarrollo de toda la 3ra generación de ordenadores.

4°

Generación de computadoras – 1971 a 1981: A partir de esta etapa las

computadoras personales se convierten en las protagonistas de la informática.

Todos los elementos que conforman la CPU ahora se almacenan en un circuito

integrado conocido como microprocesadores y empiezan a surgir una gran gama de

estos elementos fabricados por la compañía Intel, reconocida en la actualidad

como la mayor fabricante de circuitos integrados del mundo. El primer

microprocesador denominado 4004 lo desarrolla Intel en 1971 y en 1974 se

presenta al mercado el primero diseñado para uso general. Es en esta generación

donde aparece el disquete.

5°

Generación de computadoras – 1982 a 1989: Dos hechos históricos marcan

el inicio de esta etapa. Por un lado el proyecto 5ta generación comando por

Japón en 1982, cuya finalidad principal era construir ordenadores con

tecnología más avanzada bajo lenguajes de programación más potentes para las

máquinas y menos complejos para los usuarios. Por otro, la construcción del

primer superordenador con capacidad de proceso paralelo por parte de Seymour

Cray y su compañía Control Data Corporation denominado CDC 6600. En esta

generación las computadoras empiezan a realizar tareas que aún en la actualidad

predominan, como la traducción automática de una lengua a otra. Asimismo, el

almacenamiento de información digital se procesa en gigabytes y surge el DVD.

6°

Generación de computadoras – 1990 hasta la actualidad: Aunque se presentan algunos

desacuerdos sobre la existencia de una 6ta generación de computadoras, lo

cierto es que la informática no se ha detenido y cada día avanza a mayor

escala. La inteligencia artificial, la arquitectura vectorial y paralela de los

ordenadores y la incorporación de chips de procesadores especializados para

llevar a cabo ciertas tareas, predominan en la actualidad. Sin embargo, aún

queda un largo camino por recorrer para la tecnología digital y de acuerdo con

expertos de la industria como el gran Stephen Hawking, la próxima generación

estará marcada por el máximo desarrollo de la informática cuántica y su puesta

en marcha.

“La

construcción de un ordenador cuántico no supone ningún problema… Sabemos cómo

juntar las cadenas de las operaciones cuánticas sobre el papel y la forma en

que acabarán proporcionándonos un ordenador cuántico, el problema está en

trasladarlo al hardware real” Stephen Hawking.

Aprende

más sobre el funcionamiento y gestión de las tecnologías de la información. ¡Impulsa tus

habilidades tecnológicas!

para mayor informacion puede visita generaciones de las computadoras

si prefieres ver contenido visual, visita el siguiente video

si prefieres ver contenido visual, visita el siguiente video

HISTORIA DE MICROSOFT

|

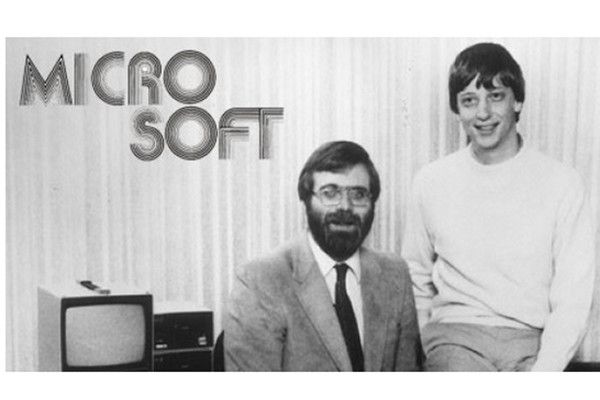

| Bill Gates y Paul Allen |

Microsoft es una compañía multinacional que fue fundada en Estados

Unidos por Bill Gates y Paul Allen. Es reconocida por desarrollar tanto

dispositivos tecnológicos (hardware) como sistemas operativos, con el

mismo nombre de la empresa, para computadores, celulares y demás.

En 1975, Bill Gates leyó en la revista

Popular Electronics que la empresa MITS había lanzado el microordenador Altair

8800. Para entonces, él había pensado en desarrollar un

lenguaje de programación que facilitara el uso de los ordenadores, así que

llamó a la MITS y les ofreció el lenguaje. Luego de trabajar ocho semanas junto

a Paul Allen, su lenguaje funcionó a la perfección, y la MITS comenzó a

distribuirlo bajo el nombre de Altair BASIC. Al saber la noticia, Bill Gates abandonó la

Universidad de Harvard y se trasladó a Albuquerque, Nuevo México, donde fundó

Microsoft. Un año después, en 1976, la marca fue registrada.

Debido al éxito del lenguaje que habían programado, Microsoft pudo abrir su

primera sede internacional en 1978 en Japón, llamada ASCII. Y para 1979, la

compañía se trasladaría de Albuquerque a Belleveu, en Washington. En 1980

Microsoft lanzaría su primer sistema operativo, el cual era una variante de

Unix, que incluía el famoso procesador de texto Microsoft Word. Las versiones

de prueba de este fueron vendidas a través de la revista PC World, y su éxito

fue inmediato.

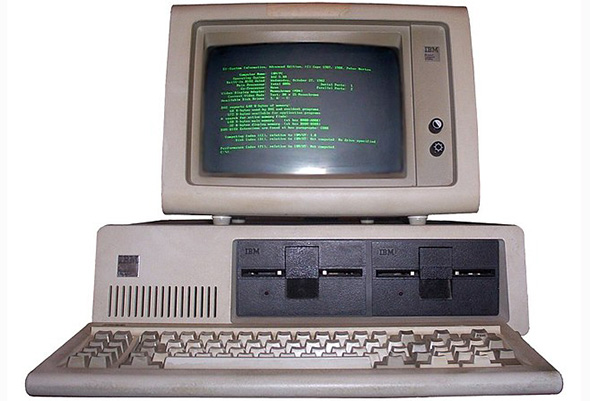

Sin

embargo, no

fue sino hasta 1981 en que Microsoft triunfaría realmente, al desarrollar el

sistema operativo DOS. IBM había contratado a Microsoft para

desarrollar un sistema operativo CP/M para su nuevo ordenador, PC IBM. Así que

Microsoft compró el 86-DOS a Tim Paterson y la renombró como PC-DOS. Por la

probabilidad de que este infringiera las normas de copyright, este sistema

operativo fue vendido a tan sólo 40 dólares. Lo determinante en el crecimiento

de Microsoft fue que la PC IBM fuera reproducida por Columbia Data Products,

por lo que el mercado se llenó de ordenadores con las mismas características.

Como Microsoft tenía una copia del sistema operativo bajo su disposición,

comenzó a reproducirla en masa para todo ese mercado emergente.

Sin

embargo, no

fue sino hasta 1981 en que Microsoft triunfaría realmente, al desarrollar el

sistema operativo DOS. IBM había contratado a Microsoft para

desarrollar un sistema operativo CP/M para su nuevo ordenador, PC IBM. Así que

Microsoft compró el 86-DOS a Tim Paterson y la renombró como PC-DOS. Por la

probabilidad de que este infringiera las normas de copyright, este sistema

operativo fue vendido a tan sólo 40 dólares. Lo determinante en el crecimiento

de Microsoft fue que la PC IBM fuera reproducida por Columbia Data Products,

por lo que el mercado se llenó de ordenadores con las mismas características.

Como Microsoft tenía una copia del sistema operativo bajo su disposición,

comenzó a reproducirla en masa para todo ese mercado emergente.

Para 1985 ya funcionaba en Irlanda la primera sede de producción internacional

de Microsoft. Ese mismo año también se lanzó al mercado Microsoft Windows,

y, junto a IBM, la compañía desarrolló el sistema operativo OS/2, el cual fue

vendido al lado del ordenador PS/2. En 1986, la oficina central de Microsoft se

mudó a Redmond, en el mismo estado de Washington. Para esa fecha también se

produjo el programa ofimático Microsoft Works, el cual contenía un procesador

de texto, un sistema para bases de datos, una hoja de cálculo y demás

aplicaciones útiles para oficinistas e investigadores. Este fue vendido en un

primer momento como una aplicación incluida en el Apple Macintosh, pero después

se vendería en CD junto a otras aplicaciones, como Microsoft Bookshelf. Ya para

1989, se

lanzaría Microsoft Office, el cual, a diferencia de Microsoft Works, era una

suite donde los programas ofimáticos funcionaban por separado, como Word y

Excel.

En 1990 fue

lanzado Windows 3.0, el cual logró vender 100.000 copias en sus primeras dos

semanas. Para el año siguiente, Bill Gates decretó que la compañía ya no

trabajaría en el OS/2, el cual fue reemplazado rápidamente en el mercado por el

sistema Windows, volviéndose el SO favorito alrededor del mundo. Mientras

tanto, la suite de Microsoft Office se posicionó por encima de sus

competidores, como Lotus 1-2-3 y WordPerfect.

En 1992 salió al

mercado Windows 3.1, el cual fue promocionado por televisión y logró 3 millones

de ventas en tan sólo dos meses. Al año siguiente, la compañía desarrolló la

primera enciclopedia para computadores, Microsoft Encarta. En

1995, tras el fracaso de Windows Bob, se lanzó Windows 95, el cual obtuvo

millones de ventas en su primer día de lanzamiento. Tras el auge del Internet, la compañía integró Internet Explorer

gratis a su Sistema Operativo y lanzó la colección de servicios MSN. Asimismo,

en 1996 se alió con la NBC para desarrollar un canal de noticias.

En 1992 salió al

mercado Windows 3.1, el cual fue promocionado por televisión y logró 3 millones

de ventas en tan sólo dos meses. Al año siguiente, la compañía desarrolló la

primera enciclopedia para computadores, Microsoft Encarta. En

1995, tras el fracaso de Windows Bob, se lanzó Windows 95, el cual obtuvo

millones de ventas en su primer día de lanzamiento. Tras el auge del Internet, la compañía integró Internet Explorer

gratis a su Sistema Operativo y lanzó la colección de servicios MSN. Asimismo,

en 1996 se alió con la NBC para desarrollar un canal de noticias.

En 1998 salió al mercado Windows 98, y fue abierta la segunda

sede más grande de la empresa en India. Los años siguientes, la compañía vio un

crecimiento exponencial tanto de sus ganancias como de su personal, lanzando

diferentes sistemas operativos entre los que se destacan Windows 2000, Windows XP,

Windows Vista, Windows 7 y Windows 10. Sin embargo, Microsoft tuvo

que enfrentar varios juicios en los que se le acusaba tanto de robo de

contenido como de monopolizar el mercado, así como tuvo que defenderse de las

críticas ejercidas por los desarrolladores y usuarios de los softwares libres,

como Richard Stallman. Para la crisis de 2008, la compañía vio un descenso en

sus ingresos, pero no condujo a problemas mayores.

Actualmente, la

compañía tiene presencia en más de 102 países y cuenta con ingresos superiores

a los 93.820 millones de dólares (cifra que logró en el 2015), posicionándola entre las cinco

compañías más prósperas del mundo

para mayor informacion puede visitar historia de microft

si prefieres material visual, puedes ver el siguiente video

si prefieres material visual, puedes ver el siguiente video

COMO USAR OFFICE

Microsoft Office es un paquete

de programas informáticos para oficina desarrollado por Microsoft

Corp. (una empresa estadounidense fundada en 1975). Se trata de un

conjunto de aplicaciones que realizan tareas ofimáticas, es decir, que

permiten automatizar y perfeccionar las actividades habituales de una oficina.

En los siguientes link les dejare archivos pdf donde estan pasa a paso como usar los programas ofimaticos de microsoft office.

Los link los mandaran directo a MEGA es una plataforma libre para almacenar documentos videos musica etc.

LINK PARA EXCEL:

https://mega.nz/file/2howBAYa#YkGfP74lbNmtRJ7Y1Osm6g-rs48OOjOsgN5uz2QTboI

LINK PARA POWER POINT: https://mega.nz/file/e4gUyYTR#X4ditD1uvtZx_fBXVLQxMbOdTFyFcffV_76h6S_QYr8

LINK PARA WORD:

https://mega.nz/file/CppSmAJY#CdFNbUVWjjLzciW1sdI6lTgmBwNCIItxsDFo_EQcTzU

COMO DESCARGAR ARCHIVOS DE MEGA

conclusion:

LINK PARA EXCEL:

https://mega.nz/file/2howBAYa#YkGfP74lbNmtRJ7Y1Osm6g-rs48OOjOsgN5uz2QTboI

LINK PARA POWER POINT: https://mega.nz/file/e4gUyYTR#X4ditD1uvtZx_fBXVLQxMbOdTFyFcffV_76h6S_QYr8

LINK PARA WORD:

https://mega.nz/file/CppSmAJY#CdFNbUVWjjLzciW1sdI6lTgmBwNCIItxsDFo_EQcTzU

COMO DESCARGAR ARCHIVOS DE MEGA

conclusion:

vivimos en un mundo donde la tecnología

avanza a velocidades irracionales intentando solventar los problemas de

la vidas cotidiana pero a la vez se genera un arma de doble filo con el cual

nos podríamos cortar, en este blog hasta el momento hemos conocido sobre

invenciones que nos han ayudado a mejorar en el área administrativa,

empresarial y ofimática, pero están invenciones también nos han ocasionado

algunos problemas para nuestro ecosistema en próximas publicaciones haremos

espacio para un tema llamado tecnología de doble filo donde hablaremos de lo

bueno y malo que nos trae la tecnología, Microsoft ha sido una de las empresas

que nos han llevado hasta el nivel de avance computacional que tenemos en la

actualidad, Windows que es el sistema favorito para muchos ha tenido sus

evoluciones pare que sería de un buen

sistema operativo sin una máquina que ejecute este programa de sistema con

una buena fluidez por ese motivo es bueno saber sobre las generaciones de la computadoras,

como muchos saben entre más corre el tiempo muchas maquinas empezaran a dejar

de funcionar no por el hecho de ser antiguas aun que podría ser un factor pero

algunas dejaran de funcionar por que la empresa de Microsoft emperezara a sacar de línea muchos Windows entonces

las maquinas que tienen sistemas fuera de línea dejaran de funcionar, debemos empezar

a actualizarnos no por el hecho de trabajar y tener un mejor sueldo en realidad

debemos hacerlo porque cada vez la forma de funcionar nuestra vida cotidiana

involucra más tecnología. No debemos tener miedo ya que la tecnología

funcionara como nosotros la usemos si hacemos mal uso entonces será mala si

hacemos buen uso la tecnología será buena.

bibliografia:

Exelente tema

ResponderEliminarImpresionante Tomås, te felicito, gracias por compartirnos estos temas tan importantes

ResponderEliminarBuenos días, su tema me parece interesante, es asombroso ver como las tecnologías han revolucionado el mundo. Cuando pienso en la primera computadora creado por los chino denominada ABACO, luego las computadoras eléctricas eran tan grandes que solo podrían caber en una plante de los edificios de la universidad. Y ahora un celular tiene más funciones que que esas computadoras gigantes de antaño. En ese contexto,, me quedo esperando los nuevos avances que se alcanzarán en este campo, tecnologías que probablemente ya no usaremos nosotros, si no, la nuevas generaciones. Saludos y buen tema.

ResponderEliminarExcelentemente información muy importarte y valiosa describir lo es la tecnología y ver la evoluciona que se ha ido desarrollando en la diferentes herramienta y la utilidad que nos dan en estos días.

ResponderEliminar